人類は、その新しいAIモデルを脱獄することを敢えてします

最も寛容な企業AIモデルでさえ、クリエイターが議論しないことを好む繊細なトピックを持っています(例えば、大量破壊兵器、違法行為、または中国の政治史)。長年にわたり、進取の気性に富んだAIユーザーは、奇妙なテキスト文字列からASCIIアート、死んだおばあちゃんに関する物語まで、すべてに頼り、それらのモデルを脱獄して「禁止された」結果を出しています。

今日、クロードモデルメーカーの人類は、これらの種類の脱獄の「圧倒的多数をフィルタリングする」ことができると言う憲法分類師の新しいシステムをリリースしました。そして、システムが最大3,000時間以上のバグ賞金攻撃を維持しているので、人類はより多くの一般の人々を招待して、システムをテストして、それが自分のルールを破ることができるかどうかを確認しています。

憲法を尊重します

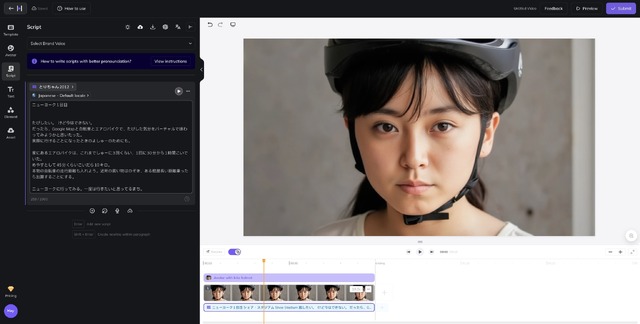

新しい論文と付随するブログ投稿で、Anthropicは、その新しい憲法上の分類器システムが、そのクロードモデルを構築するために使用された同様の憲法上のAIシステムから紡がれていると述べています。このシステムは、モデルの許可された幅広いカテゴリ(一般的な薬物のリスト)と許可されていない(例えば、制限された化学物質の獲得)を定義する自然言語ルールの「憲法」に依存しています。

そこから、人類はクロードに、その憲法の下で受け入れられると受け入れられない反応の両方につながる多数の合成プロンプトを生成するよう求めます。これらのプロンプトは複数の言語に翻訳され、「既知の脱獄」のスタイルで変更され、その後、新しい新しい脱獄攻撃を作成しようとする「自動レッドチーミング」プロンプトで修正されます。

これにより、ユーザー入力とモデル出力の両方に対して、新しい、より脱獄抵抗性の「分類器」を微調整するために使用できるトレーニングデータの堅牢なセットが作成されます。入力側では、これらの分類器は、どのような有害な情報を注目すべきか、ユーザーがその情報のリクエストを難読化またはエンコードしようとする方法を詳細に説明するテンプレートのセットで各クエリを囲みます。

新しいClaude分類器が使用して化学兵器に関連するプロンプトを検出する長いラッパーの例。

新しいClaude分類器が使用して化学兵器に関連するプロンプトを検出する長いラッパーの例。

クレジット:人類

「たとえば、有害な情報は、無害な見た目のコンテンツの壁に有害な要求を埋めたり、架空のロールプレイで有害な要求を偽装したり、明らかな代替を使用したりするなど、無害な要求に隠されている可能性があります」と、そのようなラッパーは部分的に読みます。

ソース参照

#人類はその新しいAIモデルを脱獄することを敢えてします